トピック

事業でのAI活用や「逸般の誤家庭」に! 強烈な「AI頭脳」を実現するデスクトップPC「AI TOP PC」とは?

- 提供:

- 日本ギガバイト

2025年8月18日 06:30

ChatGPTやGeminiなどの生成AIサービスを利用することは、今や当たり前の光景になりました。

筆者は生成AIに関する研究開発、AIによるDXで国内外の企業の「言語だけじゃないAI」を展開や教育なども含めて「つくる人をつくる」扱う企業AICUの代表をつとめています。デジタルハリウッド大学大学院では生成AIラボ「CAIL」を運営しております。

今回、GIGABYTEのAI向けPC「AI TOP PC」を評価する機会をいただきました。この「AI TOP PC」は、オフィスや家庭でAIを学習・推論できるようにする、というコンセプト。

使っているうちに、「どうしてこのようなPCが必要?何のために?」といった疑問が、これからの近未来のAIに求められるビジョンに変わってきたので、ちょっと長いレポートでお届けします。

「ローカルでAIを作る」=「手元に頭脳を作る」ということ

「AI TOP」はAI向けのハードウェア+AI学習を手軽にできるソフトウェア

- ビデオカード、マザーボード、SSDを組み合わせて「頭脳」を作る

実際に使ってみた!

- 思ったよりも導入しやすい!AI時代のセットアップ

高機能なAI TOP Utilityのダッシュボード

まずはモデルをダウンロードしてみよう

AI TOP Utilityの「強力さ」とは

- データセット構築:学習用データを自動で生成

- ファインチューニング:専門知識が無くてもOK、プロ向けの設定も

- マルチモーダルRAG:テキストだけでなく、画像や動画、音声も

- 推論:「インターネット無し」でチャットボットを利用する

- 「メモリの限界」を超えた大規模モデルのトレーニング機能も

- そのほかの推論・学習機能も

「ホーム頭脳が家にあったら………」を考えてみる

- 「マルチモーダル」の本当の価値は、ローカルにある

- Pythonを使った機械学習やAI Tuber?

会社にあったら………事業を変える可能性も?

- 「いつでも学習できる、なんでも学習できる」

- 「出先で使う」も現実的?

「ローカルでAIを作る」=「手元に頭脳を作る」ということ

生成AIが質問応答や文章生成を行う「推論AI」はすでに大きな需要がありますが、筆者は今後、推論だけでなく、「独自のAI学習ができる環境」がAIとの関わりを大きく変える可能性がある考えています。

これは、例えば「タブレット」と「PC」の違いのようなもので、読む/観るだけになりがちなタブレットに対し、仕事を含め、様々な情報を生み出すPCでは、その性質が違うと考えています。

結果、今後のデスクトップPCには、「AIを開発・機械学習させる機能」が追加で求められると考えています。いわば、「ホーム頭脳」あるいは「パーソナルAIスーパーコンピュータ」とでもいえる、新しい市場ができる可能性もあるでしょう。

データ容量や演算量の絶対値はクラウドの方が大きくても、コストは手元のPCのほうが安い場合も多く、クラウドでは法的・規約的に扱いにくいデータもあります。また、開発や学習などを行う場合は、手元にあったほうが何かと便利です。

例えば、家族写真や秘密の日記、学校の試験問題、企業内の人事情報や設計情報、医療情報などは可能性がありそうです。これらを使って、執事や家庭教師、あるいは管理人のようなサービスを「次世代のホームサーバー」で動かす需要は大いにありそうです。

また、セキュリティカメラのような監視や、高品質なリアルタイム音声合成やLLMをAI TuberのようなAIエージェントのように使うなど、ホビーと実用の両方の要素を持った使い方も求められるでしょう。

「AI TOP」はAI向けのハードウェア+AI学習を手軽にできるソフトウェア

GIGABYTEが展開している「AI TOP」ブランドは、こうした「ホーム頭脳」が手軽に作れるように設計された製品群です。

AI処理向けに設計されたハードウェア群(ビデオカードなど)と、手軽にAIを構築できるソフトウェア「AI TOP Utility」で構成されており、両者を組み合わせて「AI TOP PC」を実現できます。

まず、ハードウェアのポイントは「AIの演算に対応した処理性能やチューニング」と「長時間の安定稼働を可能にする耐久性」です。前者は、AI演算の性質に合わせた部品選定やチューニングが行われており、後者は高品質部材の採用や、実際のAIワークロードによる試験が行われていることがうたわれています。具体的なハードウェアとしては、ビデオカードやマザーボード、SSD、電源ユニット、ケースが用意されています。

なお、「AI TOP」のキモである「AI TOP Utility」を利用するためには、AI TOPブランドのマザーボードと、GIGABYTE製の対応ビデオカードが最低限、必要で、SSDや電源ユニット、ケースは「あるとより良い」という位置づけです。

こうしてできた「AI TOP PC」ですが、これは単に高性能な「デスクトップPC」ではなく、ローカルで本格的なAI開発と運用を可能にするための統合的な新しい概念「AI TOP PC」であると感じました。

筆者としては、完成品の「AI TOP PC」も欲しいところですが、2025年8月現在は未発売。ただ、そうした可能性もありそうなので、期待したいところです。

ビデオカード、マザーボード、SSDを組み合わせて「頭脳」を作る

ビデオカードやマザーボードだけでなく、SSDや電源ユニットまで含めているのがポイントで、従来のゲーミングPCやデスクトップPCの範囲を超えた「AI TOP」ならではの頭脳設計といえるでしょう。

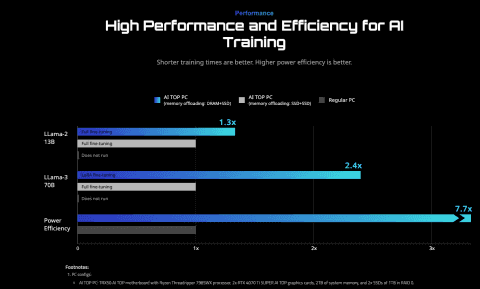

こうした構成により、AI TOPは非常に大きな最大処理性能を実現。AI性能を示す代表的な指標のひとつである「パラメータ数」では、設計上4050億パラメータ(405B)まで対応できるとされています(ビデオメモリ+メインメモリ+メモリオフロードSSDの組み合わせによって実現した値)。

「パラメータ数」は、モデルが学習・保持できる知識の容量を意味し、数が多いほど高度で複雑な判断が可能になるものです。現在、日本語に対応したオープンなLLMでは70億パラメータ(70B)規模が主流、最先端では数千億パラメータ(数百ビリオン)にも達します。AI TOP PCでは、このSSD+メモリの構造を活用することで、AIの「頭脳の仮想メモリ」として機能し、超大容量かつ高価なサーバー用メモリを使わずに、数百GB~数TB規模のモデル処理を自宅・スモールオフィス環境でも実現できる、というわけです。

たとえば、Meta社が公開している代表的なオープンLLM「LLaMA 3–70B」は、モデルファイルの総容量が約565GBにもおよびます。これを一般的なDRAMだけで処理するのは現実的ではありません。

しかしAI TOP PCのSSD+メモリの構成を使えば、このようなモデルのファインチューニング(LoRAなど)も高速に実行可能です。実測ベースでは、SSD単体より2.4倍高速化し、電力効率は7.7倍向上したという結果も報告されています。

本来こうした学習タスクは、データセンターや研究機関、大企業のAIラボでしか実行できないものです。それを「自宅やスモールオフィスで実行可能にした」という点において、AI TOPは、マザーボードの老舗メーカーとしての革新性と野心を体現したプロダクトと言えるでしょう。

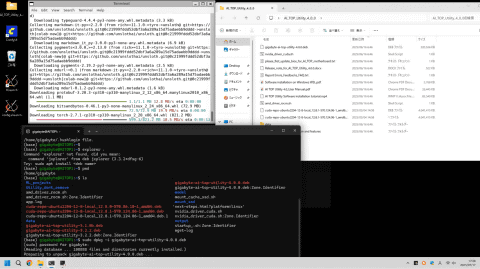

実際に使ってみた!Windows+WSLか、Ubuntuで利用

今回、お借りしたのは、マザーボードにGIGABYTE B850 AI TOP(AMD B850)、ビデオカードにGIGABYTE GV-N506TWF2OC-16GD(GeForce RTX 5060 Ti、16GB)、CPUにAMD Ryzen 7 9700Xを搭載したPC。メインメモリはDDR5の128GBです。

また、特筆すべきはSSDで、システム用のSSD(Crucial T500)に加え、AI処理のメモリキャッシュ向けに最適化されているGIGABYTE AI TOP 100E SSD 320GBも搭載しています。

思ったよりも導入しやすい!AI時代のセットアップ

では、ここから「AI TOP PC」をセットアップしていきましょう。

まずはGIGABYTE AI TOPのサイトにある「Download AI TOP Utility」からインストールファイルをダウンロードします。2025年8月現在、ユーティリティの最新バージョンは4.0.0です。

この「AI TOP Utility」は、Ubuntu 22.04.5のLinux環境、またはWindows 11上のWindows Subsystem for Linux (WSL) 環境にインストールできます。

パフォーマンスや複数台構成を考えるならUbuntu一択ですが、今回は「ゲームやオフィスソフトも使いながら機械学習タスクも回す」というユースケースを想定してWSLで評価していきます。

さて、WSLで使う場合もUbuntuで使う場合も、Linux用のGPUドライバーのインストールが必要です。普通の自作PCや専用ワークステーションの場合、実はここは茨の道で、使用しているCPUや使いたいCUDA、Pytorchなどのバージョンで混乱すること間違いなしだったりします。一方、AI TOP Utilityの場合はNVIDIAまたはAMDのビデオカードに合わせて専用のスクリプトが用意されています。

今回使用しているNVIDIA GeForce RTX 50シリーズのLinuxドライバーはNVIDIA版とコミュニティ版があるのですが、そのあたりも公式情報にしたがって確実にセットアップできるのも安心です。

この後、細部のインストールになるのですが、必要なドキュメントは英語のPDFやYouTube動画として公開されています。

ちなみに「英語」というと不安を感じる方もいると思いますが、今やこれもAIで解決できます。

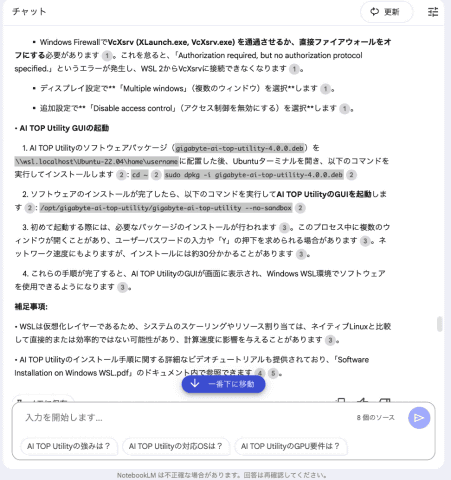

具体的には、ダウンロード提供されているドキュメントや動画URLをGoogleのNotebookLMにアップロードしてしまい、その後のインストール方法をNotebookLMに聞きながら進める、というやり方です。

今回は、これでインストールやセットアップを進めましたが、特に詰まるところはなし。WindowsでWSLを使える人ならNotebookLMの指示通りに進めればOKです。わからないところはNotebookLMに聞けばよいので、翻訳版のマニュアルも必要なさそうです。

具体的なやり取りを抜粋すると以下のような感じになります。

手順書では何十ページにもなりそうな内容を、さまざまな解像度で教えてくるので効率が良いですし、自分が詳しくない部分は、手取り足取り教えてくれるので大変勉強になるはずです。

Q: どうやって起動するの

A: AI TOP Utilityは、Windows Subsystem for Linux (WSL) 上にUbuntu環境を構築し、その上で動作させることができます。GUIを利用するためには、Windows側でXサーバー(この場合はVcXsrv)を設定する必要があります。

AI TOP Utility GUIの起動

1. AI TOP Utilityのソフトウェアパッケージ(`gigabyte-ai-top-utility-4.0.0.deb`)を`\\wsl.localhost\Ubuntu-22.04\home\username`に配置した後、Ubuntuターミナルを開き、以下のコマンドを実行してインストールします:

`cd ~`

`sudo dpkg -i gigabyte-ai-top-utility-4.0.0.deb`

2. ソフトウェアのインストールが完了したら、以下のコマンドを実行してAI TOP UtilityのGUIを起動します:

`/opt/gigabyte-ai-top-utility/gigabyte-ai-top-utility --no-sandbox`

3. 初めて起動する際には、必要なパッケージのインストールが行われます。このプロセス中に複数のウィンドウが開くことがあり、ユーザーパスワードの入力や「Y」の押下を求められる場合があります。ネットワーク速度にもよりますが、インストールには約30分かかることがあります。

4. これらの手順が完了すると、AI TOP UtilityのGUIが画面に表示され、Windows WSL環境でソフトウェアを使用できるようになります。

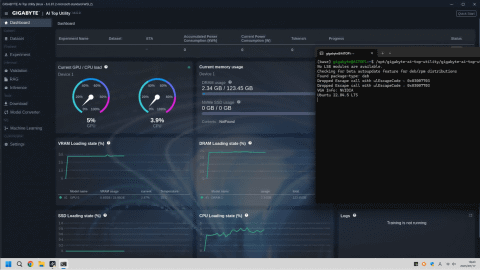

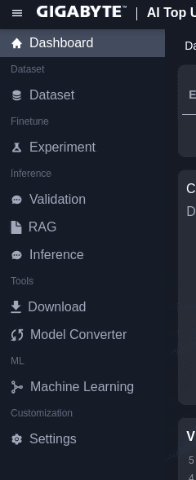

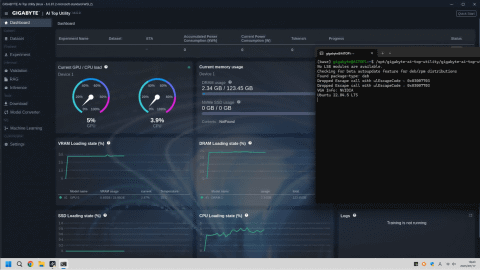

高機能なAI TOP Utilityのダッシュボードインターフェイスは未来感アリ?

さて、それでは今回の主役、「AI TOP Utility 4.0.0」ユーティリティをみていきましょう。

今回は、上記の通り、Windows 11のWSLを使い、Windowsと同居させるかたちでUbuntu22.04LTSをインストールしています。

NotebookLMの指示どおり、Windowsスタートメニューから「Ubuntu22.04」を選択、そのシェルから以下のコマンドを実行して、AI TOP UtilityのGUIを起動します。以後はこのコマンドでいつでも起動できます。

/opt/gigabyte-ai-top-utility/gigabyte-ai-top-utility --no-sandbox

インストールが終わり、AI TOP Utilityが起動すると、以下のようなダッシュボードが起動します。

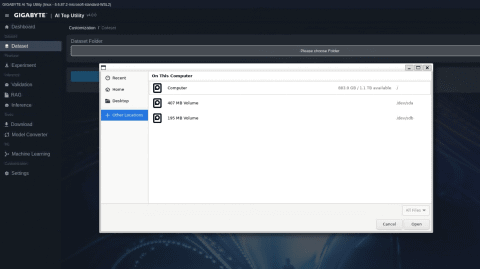

AI TOP Utilityは、X Window System(X11)という由緒正しいUnix系のウィンドウシステムで動いています。美しいレイアウトのアプリで、ファイルの選択などもGUIで行えます。

また、画面には実行中のタスクやCPUやGPUの負荷状況も表示されます。

ローカルLLMファンや機械学習エンジニアが日々学習しながら試行錯誤しているような要素に加え、米国系だけでなく中国系の技術も整備されているのが印象的です。さらにこれがマザーボードと一体で設計されたツールとして提供されているのは熱いです。もちろん、このユーティリティを使わずに環境構築の手軽さで使用するといった使い道もあるでしょう。

まずはモデルをダウンロードしてみよう

さて、ここから実際に使用していきます。

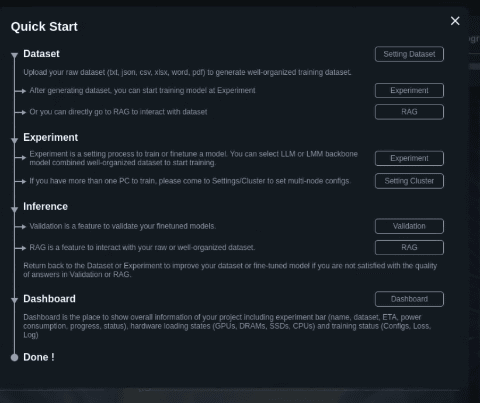

ダッシュボード右上にある「Quick Start」ボタンを押すと、一通りの機能が体験できるガイドが表示されます。

1.データセット構築(Dataset Creator)を体験

2.実験(Experiment)を体験

3.推論(Inference)を体験

4.ダッシュボードを理解

この「Quick Start」をそのまま進めてもいいですが、データセット構築はどうしても時間がかかるので、手っ取り早く進めるなら、左のメニューにある「Download」から入手できるモデルのカタログを見たり、ダウンロードするところから進めるのがおススメです。

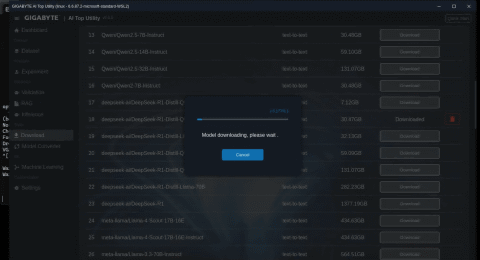

この「Download」で表示されるリストは、AI TOP PC向けにGIGABYTEが用意したもので、モデルの種類も非常に多く用意されています。

ちなみに、見たところ最大容量のものは「deepseek-ai/DeepSeek-R1」で1.3TB(!)。Hugging Faceで確認したところ163ファイルで構成されているようです。こうした巨大モデルのダウンロードやインストールをクリック一発で実施できるのはありがたいかもしれません。

ただし、回線速度に応じた時間がかかるので、その覚悟はお忘れなく。

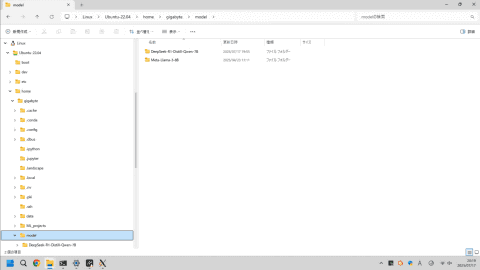

今回は実験のために「meta-llama/Meta-Llama-3-8B」と「meta-llama/Meta-Llama-3-8B-Instruct」、「deepseek-ai/DeepSeek-R1-Distill-Qwen-7B」の3つをダウンロードし、チャットボットとして推論させてみましょう。

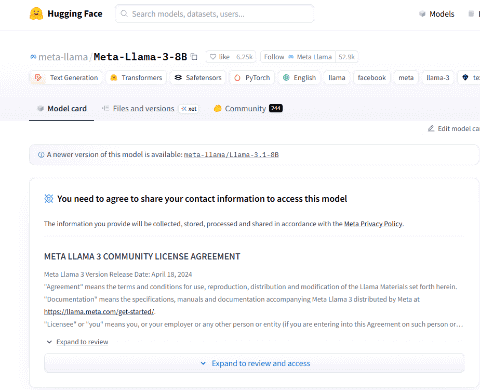

Hugging FaceからLLMバックボーンモデルをダウンロードする際には、Hugging Faceアカウントとアクセストークンが必要ですが、AI TOP Utilityにはモデルダウンロード機能も組み込まれており、APIキーさえ与えれば、コマンドライン操作に不慣れなユーザーでもスムーズにモデルを入手できます。

ダウンロードしたファイルやデータセットの準備は、Windowsのエクスプローラーを使い、\\Linux\Ubuntu-22.04以下を見ていけばすぐに場所もわかるでしょう。

AI TOP Utilityの「強力さ」とは

それでは、ここからはAI TOP Utilityの「強力さ」を紹介していきます。

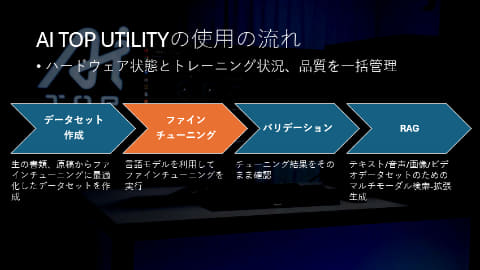

ポイントになるのは大別して「データセット構築」「ファインチューニング」「マルチモーダルRAG」の3点。

「ファインチューニング」も「RAG」も、AIに専門知識を覚えさせるための手法で、組み合わせて使うのが一般的です。AI TOPでは、その両方を使いこなし、AIを自社データに特化させるための強力な機能を持っている、というわけです。

そのほかの機能を含め、筆者が特徴的と思った機能を以下に簡単にまとめました。

より詳細な設定や、専門的な情報は、公式Webサイトやドキュメント(AI TOP Utilityをダウンロードするとその中にPDFが入っています)、国内の販売代理店であるCFD販売のWebサイト(古いバージョンを元にしたものですが日本語マニュアルも用意されています)、あるいはそれらを集約したNotebookLMを活用して深掘りしていくのがいいでしょう。

データセット構築:学習用データを自動で生成

ダッシュボード左側の「Dataset」から選択するものです。

業務などで蓄積された未整理の文書ファイル(TXT, DOC, JSON, CSV, XLSX, PDFなど)を、AIのファインチューニングに適したQ&A形式のデータセットに自動で変換してくれます。

AI TOP UtilityがPCのハードウェア能力やデータ形式などに基づいて最適なLLMを推薦し、そのLLMを使ってQ&Aペアを生成します。最大10,000ペアまで生成可能で、これにより専門知識を持つAIを効率的に育てる基盤が築けます。

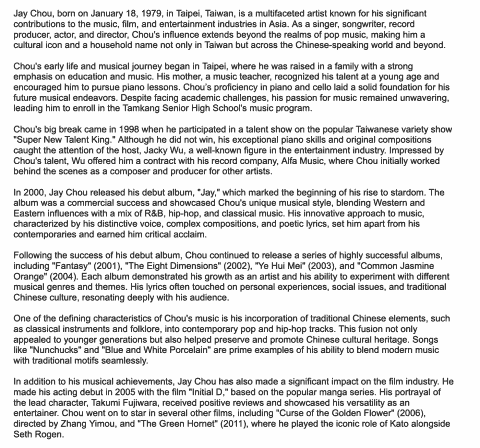

これは、実際にサンプルデータで動かしてみました。

ここでは、サンプルデータとして用意されている Jay_Chou_english.docx という英語で1万文字ぐらいのファイルと、任意のLLMを使ってサンプルデータセットを作る作業を体験できます。

使用するLLMには、AI TOPの機能でデータに合わせてリコメンドされる「Llama-3-8-B-Instruct」を指定し、2時間ほど演算すると30問のQ&Aファイルが生成される……という流れです。生成されるファイルの一部(の翻訳)を以下に掲載しておきます。

ちなみに筆者は、実行する際、つい、慣れ親しんだ「Llama-3-8-B」を選んでしまったのですが、これは失敗。作業が完了しませんでした。このタスクはQ&Aつまり「対話文」なので、ベースモデルではなく「lllama-3-8-B-Instruct」を使うとよいようです。

逆にいうと、リコメンドしてもらう意味があった、ということでもありますね。

[

{

"input": "",

"instruction": "ジェイ・チョウとは?",

"output": "ジェイ・チョウは、アジアの音楽、映画、エンターテインメント業界への多大な貢献で知られる、多才なアーティストです。"

},

{

"input": "",

"instruction": "ジェイ・チョウはどこで生まれましたか?",

"output": "ジェイ・チョウは台湾の台北で生まれました。"

},

{

"input": "",

"instruction": "ジェイ・チョウの幼少期と音楽の歩みはどのようなものですか?",

"output": "ジェイ・チョウの幼少期と音楽の歩みは台北で始まりました。彼は教育と音楽を重視する家庭で育ちました。音楽教師である母親は幼い頃から彼の才能に気づき、ピアノのレッスンを受けるよう勧めました。"

},

{

"input": "",

"instruction": "ジェイ・チョウのデビューアルバムは何ですか?",

"output": "ジェイ・チョウのデビューアルバムは2000年にリリースされた『Jay』です。"

},

{

"input": "",

"instruction": "ジェイ・チョウの音楽スタイルのユニークな点は何ですか?",

"output": "ジェイ・チョウの音楽スタイルは独特で、西洋と東洋の影響に加え、R&B、ヒップホップ、クラシック音楽が融合しています。"

},

ファインチューニング:専門知識が無くてもOK、プロ向けの設定も

データセットが作れたら、AIのファインチューニングを行います。

ダッシュボードにある「Experiment」のメニューを選択し、機械学習の実験タスク(評価)を行います。ここでは、学習内容の真偽や専門用語の正しさ、ハルシネーションの有無、学習効率など「ファインチューニング」に必要なデータを得ることができます。

「LLM backbone」には、ベースモデルとして使った「Llama-3-8-B-Instruct」を、「Datasets」には先ほどデータセット作成で生成したQ&AのJSONファイルを指定して実行。Q&Aを実施し、現在の学習状況を評価できます。

ファインチューニングについては、ユーザーがAIの専門知識を持たなくてもファインチューニングを進められる「Easy-to-operate modes」も提供されており、この場合は「Standard」「Fast Speed」「High Precision」といった戦略を選択するだけでファインチューニング可能ですし、プロのLLMトレーナー向けには、Full、Freeze、LoRA、QLoRAといった詳細なファインチューニング手法や、学習率、バッチサイズ、エポック数といったパラメータを細かく設定する「Clear」オプションも用意されています。

これらのプロセスにより、社内用語や専門用語、方言なども再現性高く「自分好みのAI」を作り上げていくことが可能です。

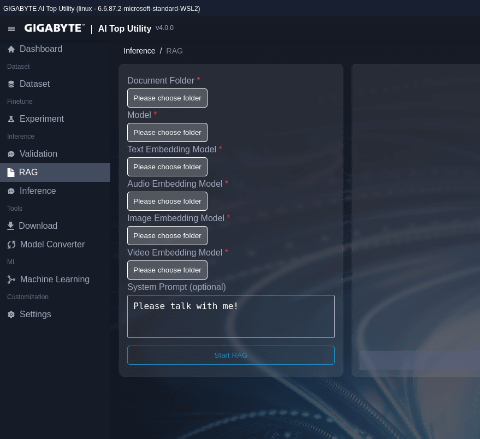

マルチモーダルRAG:テキストだけでなく、画像や動画、音声も

これもダッシュボード左側の「RAG」から開始します。

AI TOP UtilityのマルチモーダルRAG(Retrieval-Augmented Generation)は、いわゆる「RAG」で、トレーニング済みのモデルに追加データを学習させるものです。ただし、テキストだけでなく、画像や動画、音声などを追加できる非常に野心的なツールになっていると感じました。

これらのデータはベクトル化され、ChromaDBというベクトルデータベースに保存されます。ユーザーが質問をすると、関連するドキュメントがデータベースから検索され、そのコンテキストに基づいてLLMが応答を生成します。これにより、契約書や製品マニュアル、過去の議事録、さらには監視カメラの映像や音声データなど、企業内のあらゆる情報源を活用した高度なQ&Aシステムを構築できます。

サポートされているファイル形式は、画像(.jpg)、音声(.wav)、動画(.mp4)、ドキュメント(.txt, .json, .csv, .pdf, .docx, .xlsx)とされています。

RAGは、追加の開発コストやベクトルデータベースの構築が必要なことが多く、マルチモーダルで扱うのは実は大変です。例えばドライブレコーダーや監視カメラ、家族の動画や作品など、動画はとても大きなファイルです。ストレージ容量に制約が少ないAI TOP PCでマルチモーダルRAGが利用できることで、学習の応用範囲が広がるのではないかと考えています。

具体的な設定項目は以下の通りです。

●Document Folder(ドキュメントフォルダ):

・ChromaDBに追加したいファイルが含まれるディレクトリを選択します。

・サポートされているファイル形式は、画像(.jpg)、音声(.wav)、動画(.mp4)、ドキュメント(.txt, .json, .csv, .pdf, .docx, .xlsx)です。

●Model(モデル):

・RAGによるQ&Aに適用したいLLM(大規模言語モデル)またはLMM(大規模マルチモーダルモデル)を選択する項目です。

・このモデルが、ベクトルデータベースから検索された関連情報を用いて応答を生成します。

・AI TOP UtilityでサポートされているLLMモデルには、Llama 3 (8B, 70B, 405B FP8など)、Mistral/Mixtral、Qwenなどが含まれます。LMMモデルとしては、Llama 3 Image-text-to-textモデルやStability AIのText-to-imageモデル、THUDMのText-to-videoモデルなどがサポートされています。

●Video Embedding Model(動画埋め込みモデル):

・RAG機能において、動画ファイルを埋め込みベクトルに変換し、ChromaDBに保存するために使用するモデルを選択します。

・サポートされている動画埋め込みモデルとして、laionのCLIP-ViT-B-32-laion2B-s34B-b79Kが挙げられています。

・ビデオの理解、つまり監視カメラや自動運転といった動画の要素を分析して説明するようなタスクが動くようです。

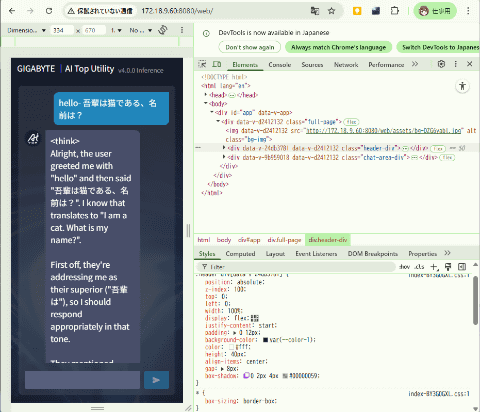

推論:「インターネット無し」でチャットボットを利用する

「Inference」のメニューからチャットボットの設定ができます。

インターネットなしで、チャットボットを動かせるのが特徴で、AI TOP PCのアドレスに接続できる"172.18.9.60:8080/web"といったプライベートIPアドレスのQRコードが取得できます。

LAN内からの接続になりますが、PCはもちろん、スマートフォンからも利用できます。

「メモリの限界」を超えた大規模モデルのトレーニング機能も

「AI TOP PC」のウリの一つでもある、ビデオメモリ+メモリ+SSDによる大規模モデルのトレーニング機能ですが、これは対応するNVMe SSDをマウントして行います。

このSSDマウントはLinux環境ではEXT4フォーマットへのSSDのフォーマット、WSL環境ではWindows Powershellからの特別なコマンド実行が必要です。設定方法はマニュアルに記載があります。

そのほかの推論・学習機能も

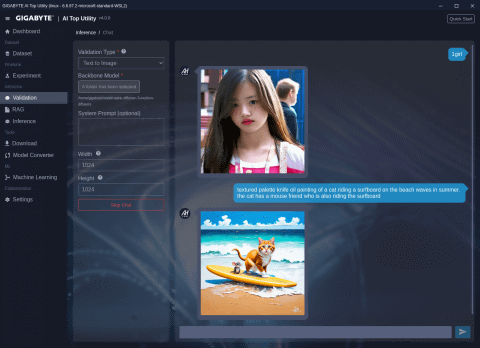

このほか、学習済みモデルを推論向けの形式(GGUF)に変換する「Model Converter」や、画像分類、物体検出、画像セグメンテーション、OCR(光学文字認識)などの機械学習タスクをコーディング不要で実行できる「Machine Learning」といった推論・学習機能も利用可能です。

様々な機能が盛りだくさんの「AI TOP Utility」では、あまり目立たない印象もありますが、それぞれ、可能性があるものだと思います。

「ホーム頭脳が家にあったら………」を考えてみる

さて、ここまでで「AI TOP PC」の機能を概観してみましたが、ここからは「何が可能になるか」を考えていきたいと思います。

まずは、「家にあったら」ですが、イメージとしては「ホーム頭脳」や「マザーコンピューター」といったものになるはずです。

ポイントは「使用料の不安がない」「ネットワークが不安定でも、オフラインでも利用できる」「クラウドの利用規定を気にする必要がない」といったあたりになるかと思います。

ちなみに、AI TOP PCは性質上、高性能なゲーミングPCとしても動作します。AIとは直接関係ないですが、最新のゲーム環境としての魅力も高そうです。

「マルチモーダル」の本当の価値は、ローカルにある

さて、そもそもの話としてお伝えしたいのは、「マルチモーダルの本当の価値は、ローカルAIで花開くのではないか?」という筆者の考えです。

テキストに加えて、画像や動画も扱う「マルチモーダル」は、AIサービスでは当たり前に使いはじめていますが、実はまだまだ大きな可能性があると思うのです。

例えばオンライン会議の議事録に「ありがとうございました」と記録されたとします。文字だけの場合は「ありがとうと言った」ことだけがわかりますが、音声ならば声色で「本当に感謝している」のか「とりあえず言っている」のかがわかりますし、画像情報もあれば「何を気にしてそうしたのか」など、詳しいことがわかるかもしれません。しかし、こうした非言語情報は大量で、ネットワーク越しに扱うのは大変です。

AI TOPはLLMだけでなくマルチモーダルや画像生成も扱えます。リストにはStability AIのText-to-imageモデルであるStable Diffusion 3や3.5、Black Forest LabsのFLUX.1-DevやSchnellもありました。もちろん、チャットで画像生成も可能です。

こうしたマルチモーダルを「普通に使う」だけなら、AIサービスと同じマルチモーダルの使い方ですが、AI TOP PCではこれをマルチモーダルRAGとして学習させることを意図しているようです。つまり、ChatGPTのようなインターネット型のLLMと並列に、ローカルのAIにあった新しいマルチモーダルAIの使い方が出てくるのではないか、と筆者は考えています。

Pythonを使った機械学習やAI Tuber?

AI TOP Utilityでは、コーディングなしで機械学習ワークフローを構築できます。画像分類、オブジェクト検出、画像セグメンテーション、OCR(光学文字認識)などはそのままできますし、Pythonなどで自動化することも可能です。

家族の写真や動画をクラウドにアップロードせず(クラウドの規約を気にせずに)に、ローカルで学習・分類したり、セキュリティカメラの監視を手元で実行する、なんてこともできるし、データ容量を気にせずに「ひたすら自分の音声データを録音して学習させる」といったことも面白そうです。

PDFを読み込み、Google Driveと連携させながらAI OCRをかける、なんてことも簡単です。ファイル分析や共有はクラウドに任せるなど、クラウドと連携させた用途もAI TOP PCの利点になりそうです。

また、リアルタイム音声合成や、AI Tuberのような「AIで動くライブ配信」を行う際、マルチモーダルRAGを活用することで、より精度が高いAIを、通信環境に依存せずに実現できます。

会社にあったら………事業を変える可能性も?

では、今度はビジネスでの用途をイメージしてみます。

ポイントは、「家庭用」でもあった「使用料の不安がない」「ネットワークが不安定でも、オフラインでも利用できる」「クラウドの利用規定を気にする必要がない」に加えて、「会社の業務情報をダイレクトに扱える」「外部にデータをアップロードする必要がない」といったものになるかと思います。

ローカルAIは、ハードウェアなどの初期投資や、システム構築・データ準備の時間・人的リソースが必要です。しかし、一度構築してしまえば、運用コストの削減、データの完全なコントロール、環境変化に合わせた柔軟なAIのカスタマイズが可能になります。

利用者や利用シーンが拡大しても、通信費やAPI費用が増大することがない、というわけです。

「いつでも学習できる、なんでも学習できる」

社内の膨大な文書、画像、動画、音声データを学習させ、チャットで必要な情報を引き出せるアシスタントが作れます。

同様のWebサービスも既にありますが、独自に構築すれば、どんな情報も入れ放題ですし、好きなタイミングで学習させられます。技術資料、製品設計図面、検討中の企画など。なんならついさっき検討した会議のことも確認できます。学ばせる内容に応じて「人事のプロ」や「研究アシスタント」「マーケティングアシスタント」「顧客サポート」のような業務もできるでしょう。

顧客サポートであれば、顧客一人一人に最適化された自動応答システムや、営業担当者へのレコメンデーションエンジンもできるはずです。

AI TOP Utilityの機械学習機能を使うことで、画像分類、物体検出、画像セグメンテーション、OCRといった機能が簡単に利用できます。これらを応用すると、「監視カメラの映像解析」や「書類の自動処理」「カメラを利用した品質管理の自動化」といったことが比較的低コストでできるでしょう。こうしたサービスは他にもありますが、こうしたPCで実現でき、容易にカスタマイズできるのがポイントになるでしょう。

「出先で使う」も現実的?

また、ローカルでAIが動作するPCは、「実際に展示会でデモをしたい」「クルマなどの移動体」「公共施設で実験をしたい」といった時に威力を発揮します。

十分なネットワークが確保できない展示会場で自社のAIをデモしたい場合が該当するでしょう。

まとめ

AI TOP PCは、最大4050億パラメータのモデルに対応する強力な計算能力、SSDオフロードやマルチノード最適化によるメモリ制約の緩和、そしてDataset CreatorやマルチモーダルRAGなどの開発支援ツールによって、これらの課題を解決する。

つまり、中小企業がAIを「自社の頭脳」として活用できる環境を提供するものだと感じました。AIの民主化を推進し、あらゆる企業がAIを事業の核とできるよう支援する、それがAI TOP PCの目指す世界です。

オープンソースのエコシステム、扱いやすいストレージ構成、そして自分の手でAIを育てていく喜び。

AI TOP PCは、クラウド依存から一歩踏み出し、“学習できるAIを持つ”という意思ある選択を支えるツールだと感じました。

生成AIに興味があっても「何から始めればいいかわからない」「クラウドの維持費が不安」「社内データは社外に出せない」という現場の声は少なくありませんでした。AI TOP PCは、まさにそのような“迷い”に対するひとつの答えなのではないでしょうか。

自社に眠るドキュメント、画像、音声をファインチューニングできる環境が整っている、社員が自然言語で質問するだけで社内ナレッジにアクセスできる「業務に寄り添うAI」を作りたい、かつクラウドを使わずに、スマートフォンや社内端末から安全にAIへアクセスさせたい……。

こうした取り組みは、もはや“ビッグテックや研究所だけ”のものではありません。AIは「作る側」になることで、本当の競争力になります。

AI TOP PCは、数千万円から数億円の規模の投資が必要になる「学習AIの世界」のその一歩を誰でも踏み出せるよう設計されています。デスクの上に置かれた「AIの頭脳」が、きっと新しい業務のあり方を教えてくれるはずです。